📍この記事は、「AIそのものが危険だ」と主張するものではなく、

“責任の構造が未設計のまま使われる高リスクAI運用”が社会的問題になりうる、という構造的な課題について論じたものです。

AIは万能だと思っていませんか?

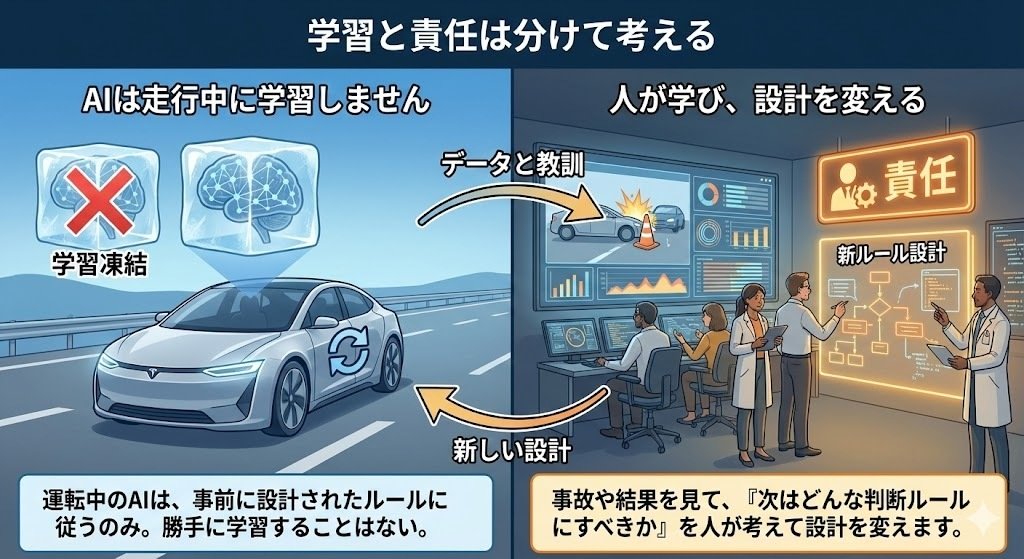

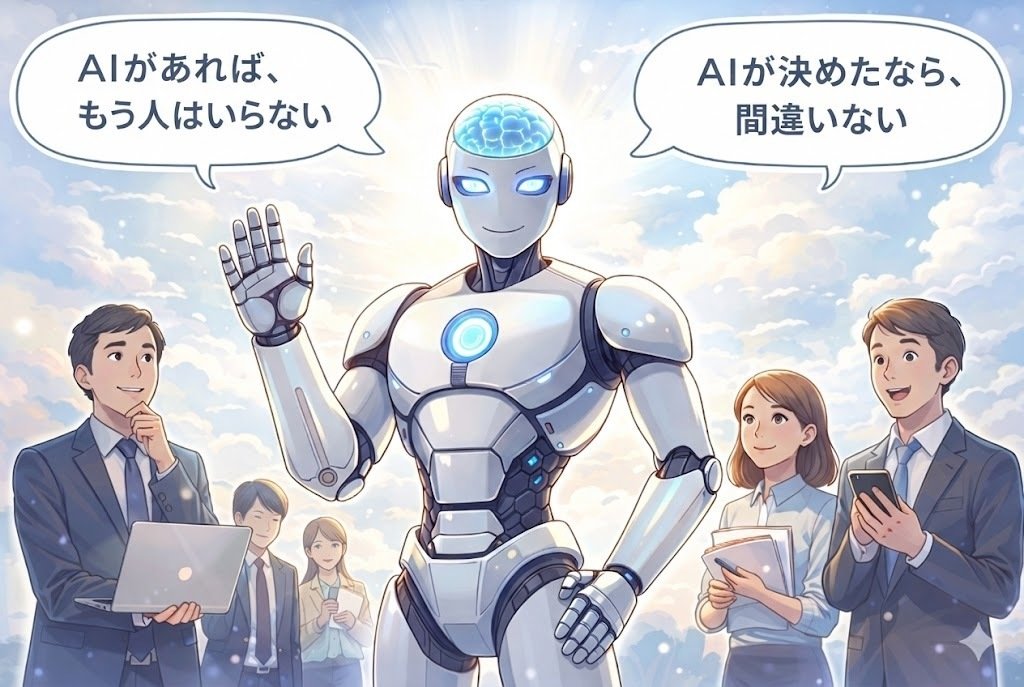

AIを万能視してしまう人々のイメージ。

AIを万能視してしまう人々のイメージ。

最近、こんな言葉をよく聞きます。

「AIがあれば、もう人はいらない」

「AIが決めたなら、間違いない」

たしかに、AIはとても賢くなりました。

文章も書けるし、画像も作れるし、難しい計算も一瞬です。

こうした日常的な用途では、

AIはとても便利で、頼れる存在です。

でも――

AIが“何でも正しく決めてくれる存在”だと思ってしまうとしたら、

それは少し危険です。

この問題が本当に深刻になるのは、

医療・金融・採用など、

一度の判断が人の命や人生に大きな影響を与える

「高リスクAI」の領域です。

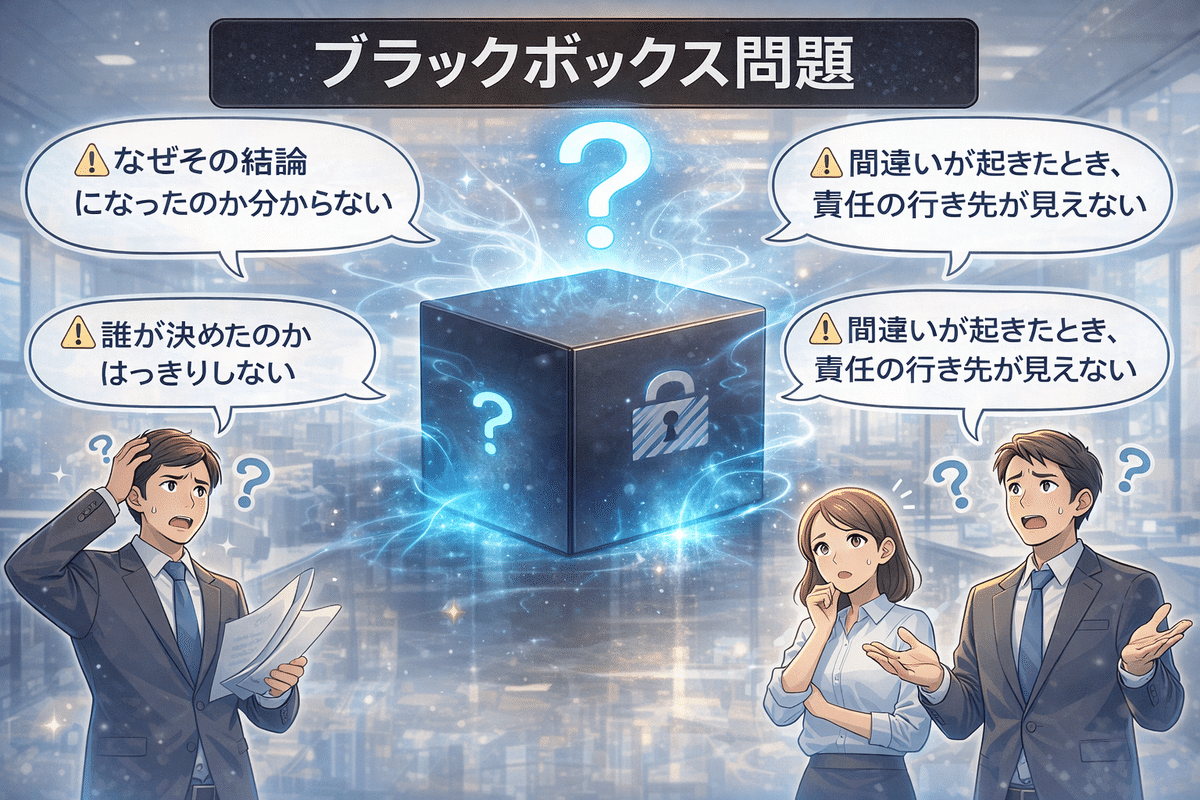

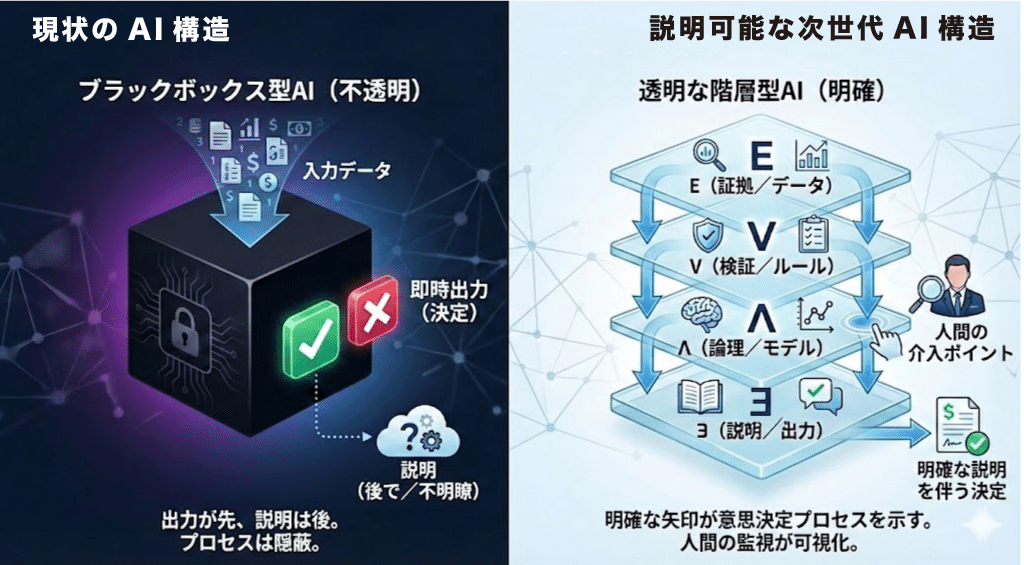

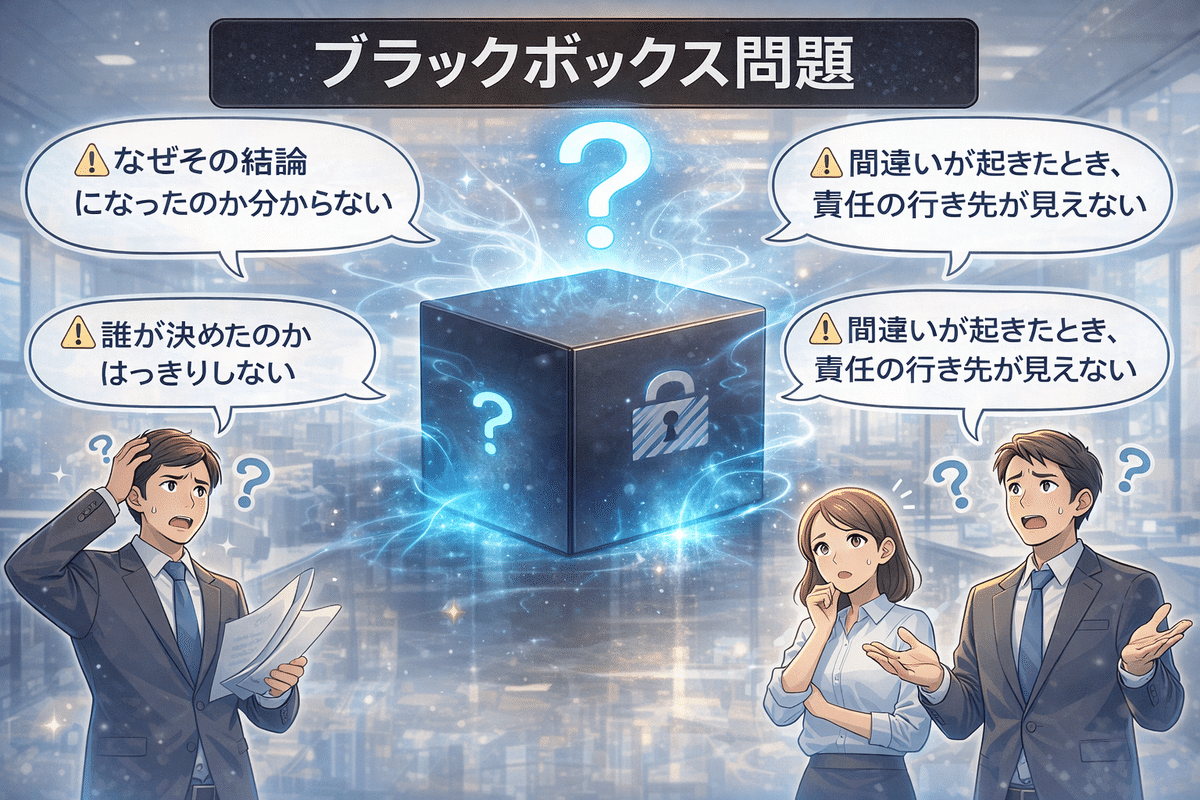

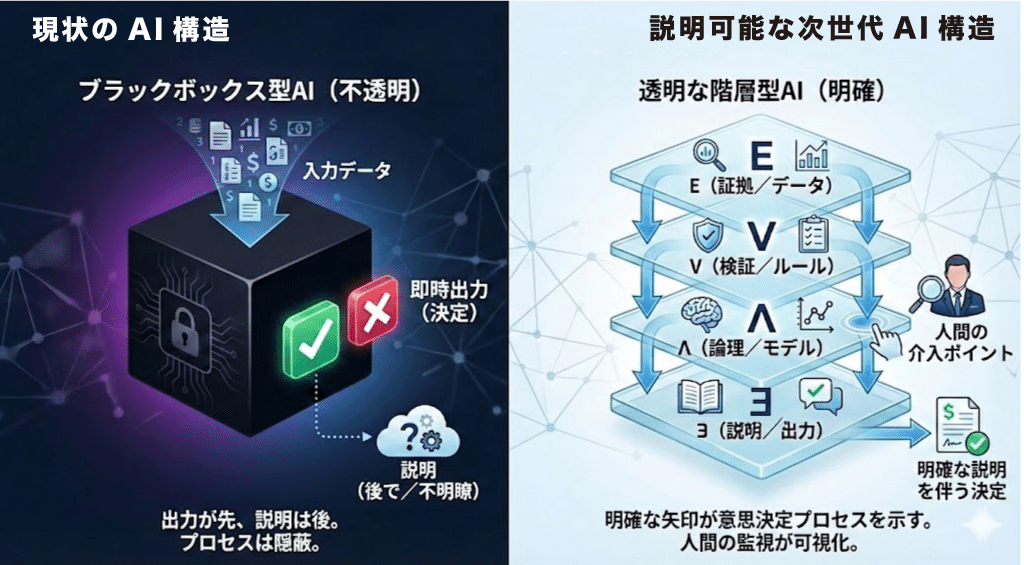

「ブラックボックス問題」って何?

AIの話になると、ときどき

「ブラックボックス問題」という言葉が出てきます。

難しそうに聞こえますが、

実はとてもシンプルな問題です。

AIが重要な判断をしているのに、

-

なぜその結論になったのか分からない

-

誰が決めたのかはっきりしない

-

間違いが起きたとき、責任の行き先が見えない

この状態をまとめて

「ブラックボックス」と呼んでいます。

現状の課題:「AI万能論」の罠とブラックボックス問題。

現状の課題:「AI万能論」の罠とブラックボックス問題。

中身が分からないことが問題なのではない

多くの人は、

「AIの中身が難しすぎて理解できないからブラックボックスなんだ」

と思っています。

でも、本当の問題はそこではありません。

問題は、

『誰が決めているのか』『どこで止められるのか』が

最初から決められていないことです。

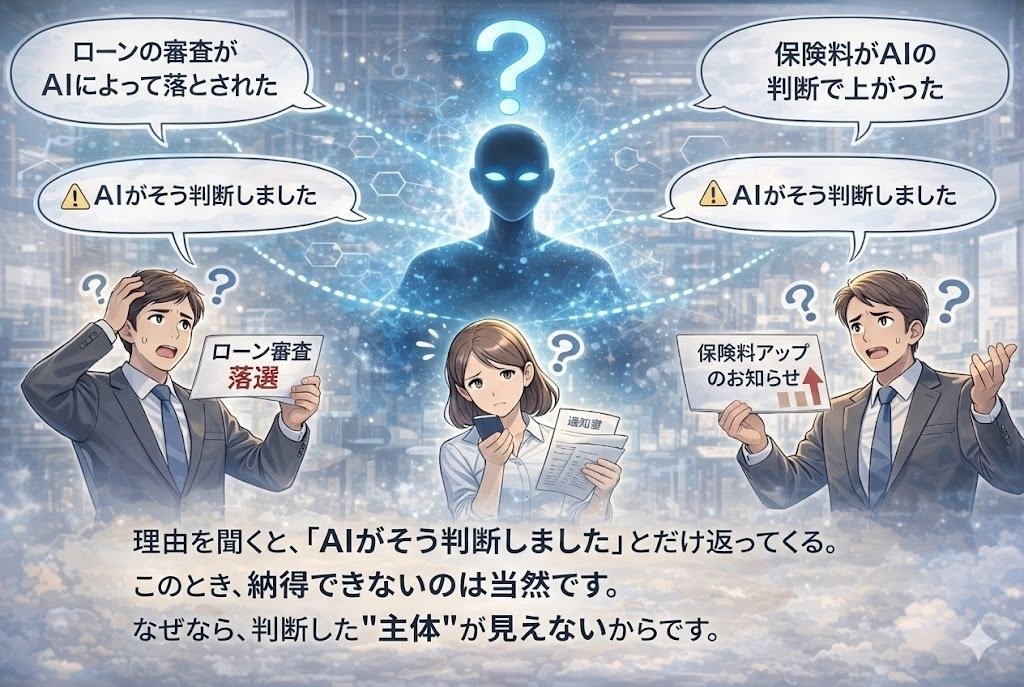

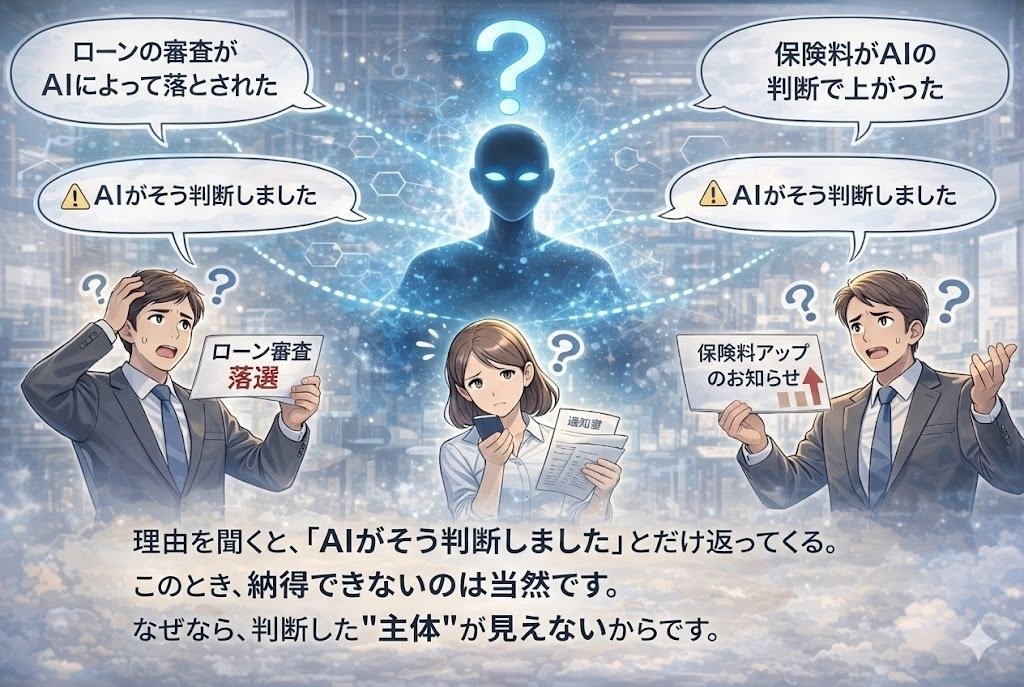

たとえば、こんな場面

-

ローンの審査がAIによって落とされた

-

採用でAIに自動的に外された

-

保険料がAIの判断で上がった

理由を聞くと、

「AIがそう判断しました」

とだけ返ってくる。

このとき、

納得できないのは当然です。

なぜなら、

判断した“主体”が見えないからです。

AIの判断理由が分からず、ローン審査落ちや保険料値上げに困惑する人々。

AIの判断理由が分からず、ローン審査落ちや保険料値上げに困惑する人々。

AIが悪いわけではありません

ここで大事なのは、

AIが勝手に暴走しているわけではないということです。

多くの場合、

-

どこまでAIに任せるのか

-

どこで人が確認するのか

-

問題が起きたら誰が責任を持つのか

これが、

最初から決められていないまま使われているのです。

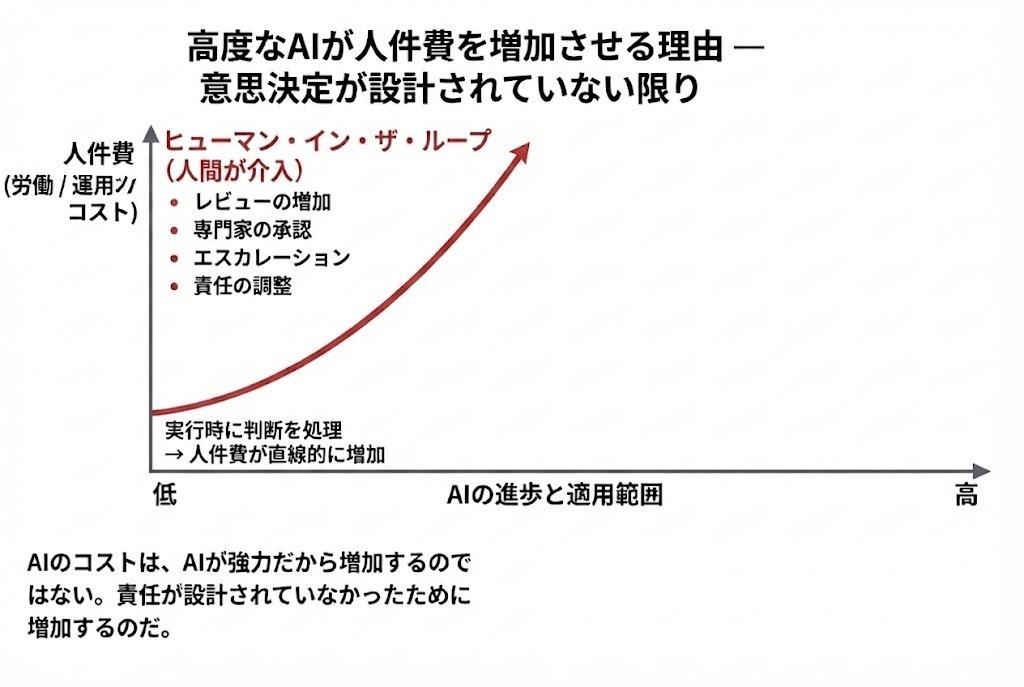

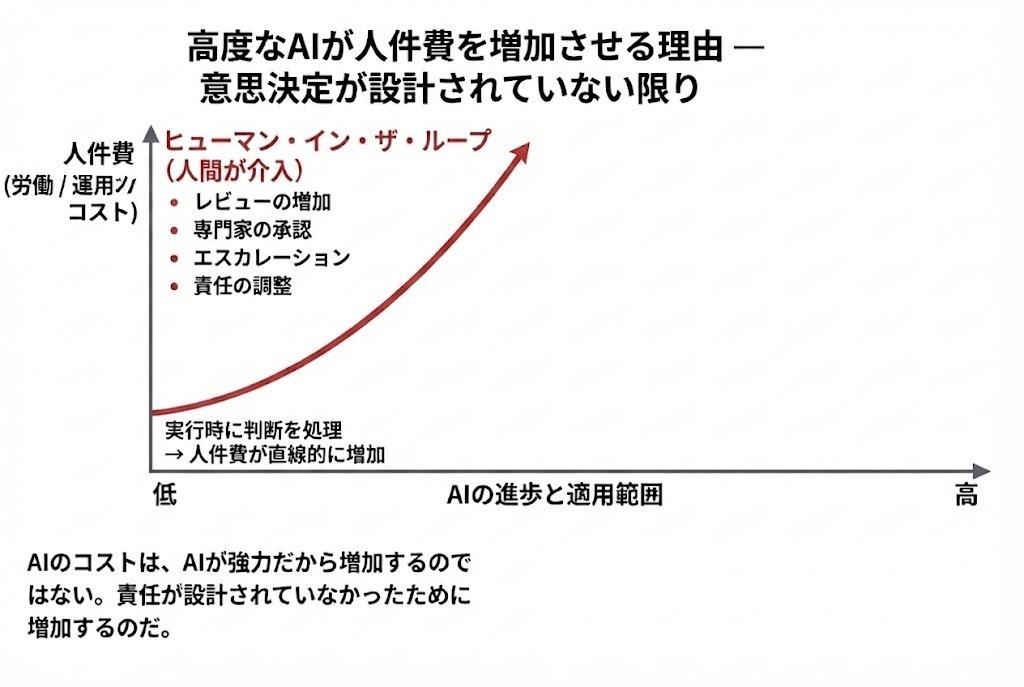

なぜ「人のチェック」がどんどん増えるのか

「じゃあ、人が全部チェックすればいいじゃないか」

そう思うかもしれません。

実際、多くの現場ではそうしています。

でも、AIが賢くなればなるほど、

チェックすべき判断の数は増え続けます。

-

毎回人が確認する

-

例外が増える

-

誰が責任を持つか調整が必要になる

結果として、

AIを入れたのに、人の負担とコストが増える

という逆転現象が起きます。

説明責任を果たせず、人の負荷とコストがかえって増大。

説明責任を果たせず、人の負荷とコストがかえって増大。

高リスクAIでは「日々のランニングコスト」も増え続ける

※ここでいう「高リスクAI」とは、

医療・金融・採用・保険・福祉・司法・公共サービスなど、

一度の判断が人の命・人生・生活に重大な影響を与える分野で使われるAIを指しています。

ここで、もう一つ見落とされがちな問題があります。

それは、高リスクAIでは、事故が起きる前から

日々のランニングコストが発生し続けるという点です。

医療、金融、採用、保険などの分野では、

「万が一」を避けるために、

-

すべてのAI判断を人が確認する

-

例外が出るたびに判断を止める

-

責任の所在を都度すり合わせる

といった運用が常態化します。

その結果、

AIが賢くなればなるほど、

人の確認作業と調整コストは増えていきます。

これは事故対応のコストではありません。

何も起きていなくても、毎日発生するコストです。

現在の課題:AIが高度化するほど、人の確認・調整コストが増加し続ける構造。

現在の課題:AIが高度化するほど、人の確認・調整コストが増加し続ける構造。

「ほぼ完璧なAI」が、いちばん危険な理由

現在のAI、とくにChatGPTのようなLLM(大規模言語モデル)は、

人間よりも賢く、自然で、

ほぼ完璧に見える答えを出します。

それはとても便利です。

しかし、

人の命や人生に直接関わる(高リスクAI)判断では、

この「ほぼ完璧」が最も危険になります。

なぜなら、

その答えが出た「あと」では、

もう取り返しがつかないからです。

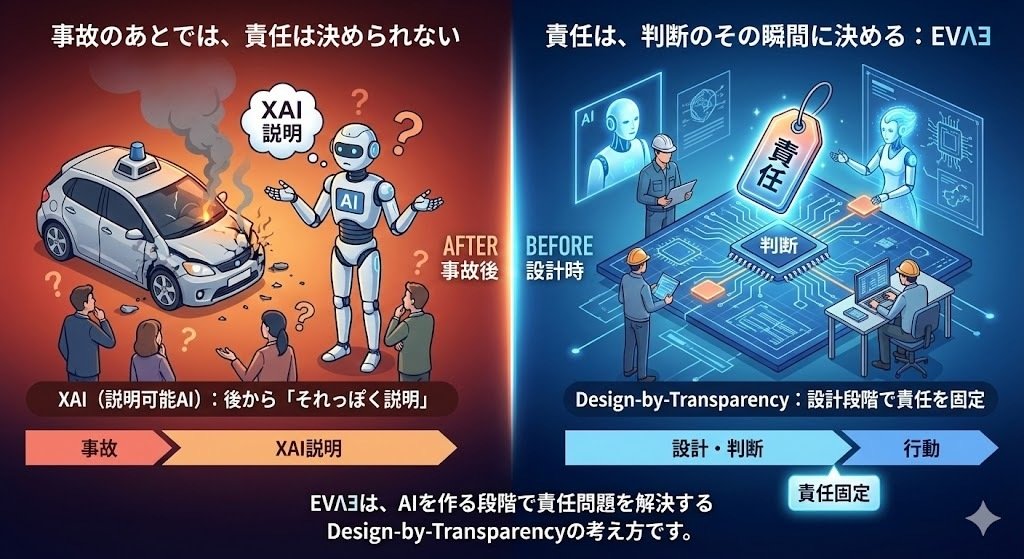

推論のあとに、さらに推論で説明するという問題

現在、多くのAIでは

「なぜその答えになったのか」を

XAI(説明可能AI)によって説明しようとしています。

しかし実際に行われているのは、

推論で出した答えを、

さらに別の推論で“説明させる”ことです。

その説明は、とてももっともらしく、

納得できそうに聞こえます。

でも、それは

責任の所在を明確にする説明ではありません。

説明が上手になるほど、

-

誰がその判断を許可したのか

-

どこで止められたはずなのか

-

誰が引き受けるべきだったのか

かえって見えなくなってしまいます。

その結果、

AIが出した説明によって、

「誰か人間が判断した」という“錯覚”だけが生まれ、

責任の空白が見えなくなってしまうのです。

これが、

AIブラックボックス問題のいちばん深いところです。

必要なのは「事後説明」ではなく、責任の所在をあらかじめ決める「事前設計」

必要なのは「事後説明」ではなく、責任の所在をあらかじめ決める「事前設計」

本当に必要なのは「あとから説明」ではない

多くの対策は、

「問題が起きたら説明しよう」

という発想です。

でも、それでは遅いのです。

大切なのは、

問題が起きる前に

『誰が決めるのか』『どこで止めるのか』を

設計しておくことです。

AIにも「設計」が必要

AIは魔法の箱ではありません。

人が決めたルールや設計の中で、

ただ計算しているだけです。

だからこそ、

これを最初から組み込むことが重要になります。

世界中が答えを探しているが、まだ決定打はない

ここまでの問題意識は、 実はあなた一人のものではありません。

いま、世界中の企業や政府、研究者たちが、

-

AIが判断したとき、誰が責任を負うのか

-

どこで人が介入・停止できるのか

-

その責任をどう技術として固定するのか

という問いに直面しています。

XAI(説明可能AI)、 人が常に確認する運用(Human-in-the-loop)、 ガイドラインや倫理原則など、 さまざまな対策が試されています。

しかし現時点では、 「判断と責任を同時に固定する構造」は、 まだ社会実装された前例がありません。

多くの組織は、 問題に気づき、答えを探し続けていますが、 決定打を見つけられずにいるのが現状です。

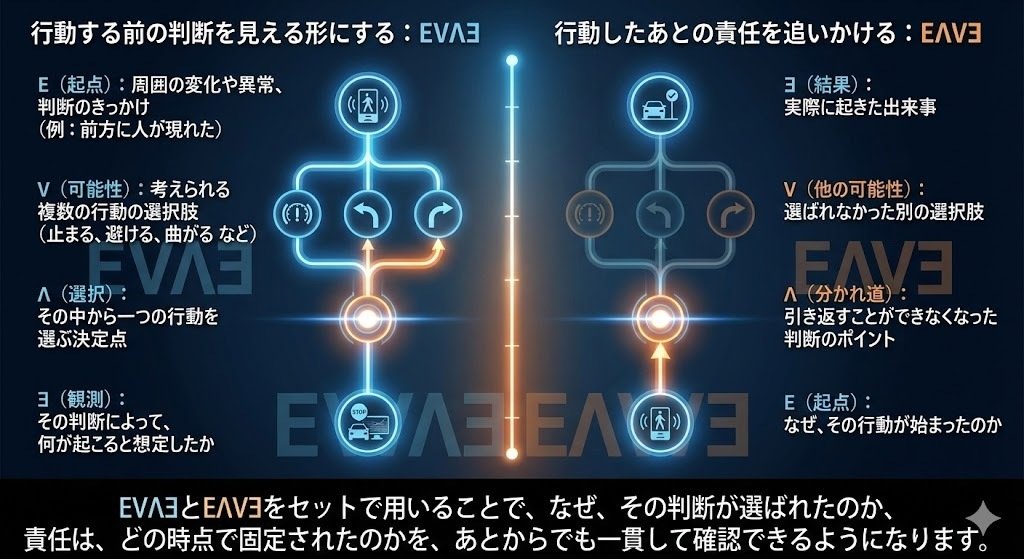

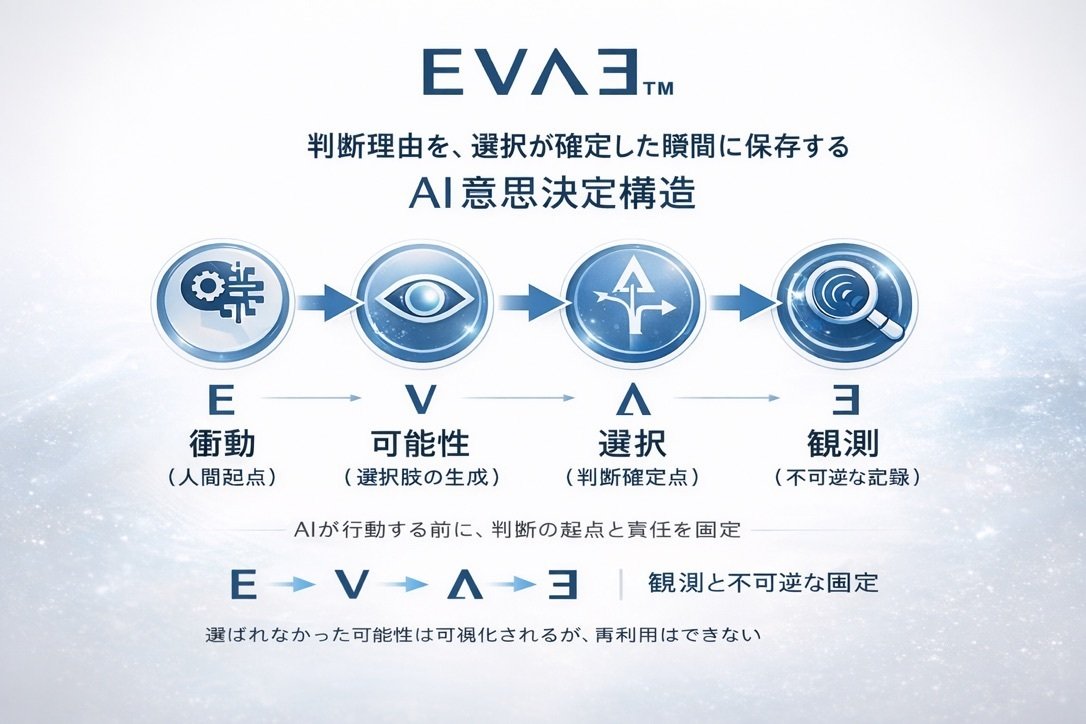

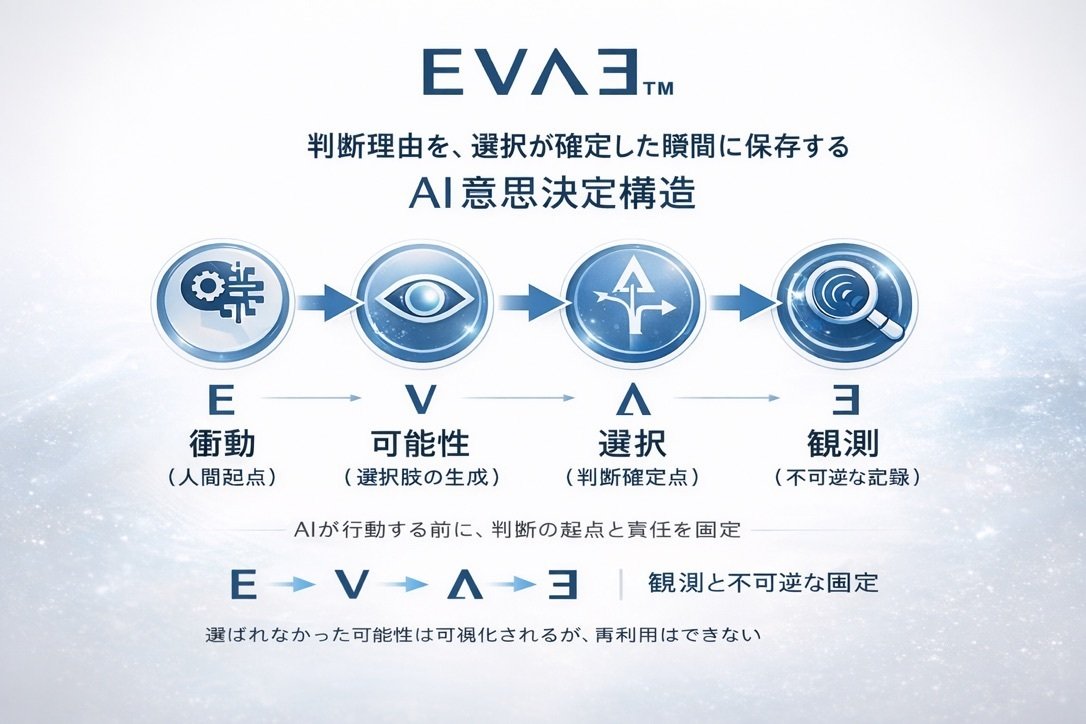

だから「EVΛƎ」のような設計が必要になる

ここまで読んで、

「じゃあ、どうすればいいの?」

と思った方もいるかもしれません。

この問いに対する一つの答えを、 構造として可視化したのが、次の図です。

AI意思決定構造「EVΛƎ」概念図:人が責任を持つための作動・検証サイクル。

AI意思決定構造「EVΛƎ」概念図:人が責任を持つための作動・検証サイクル。

「なぜ?」に答える。それが、これからのAIのスタンダード。

「なぜ?」に答える。それが、これからのAIのスタンダード。

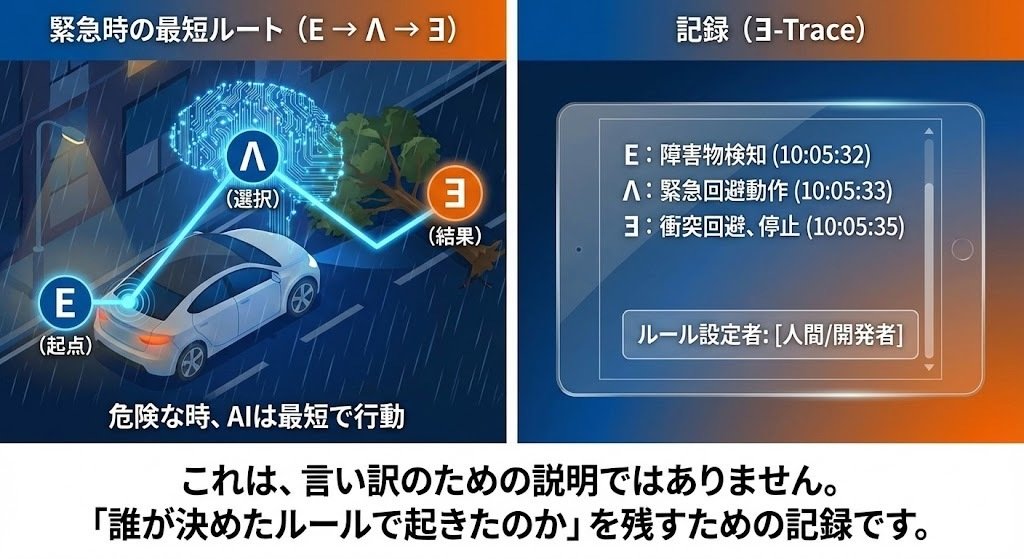

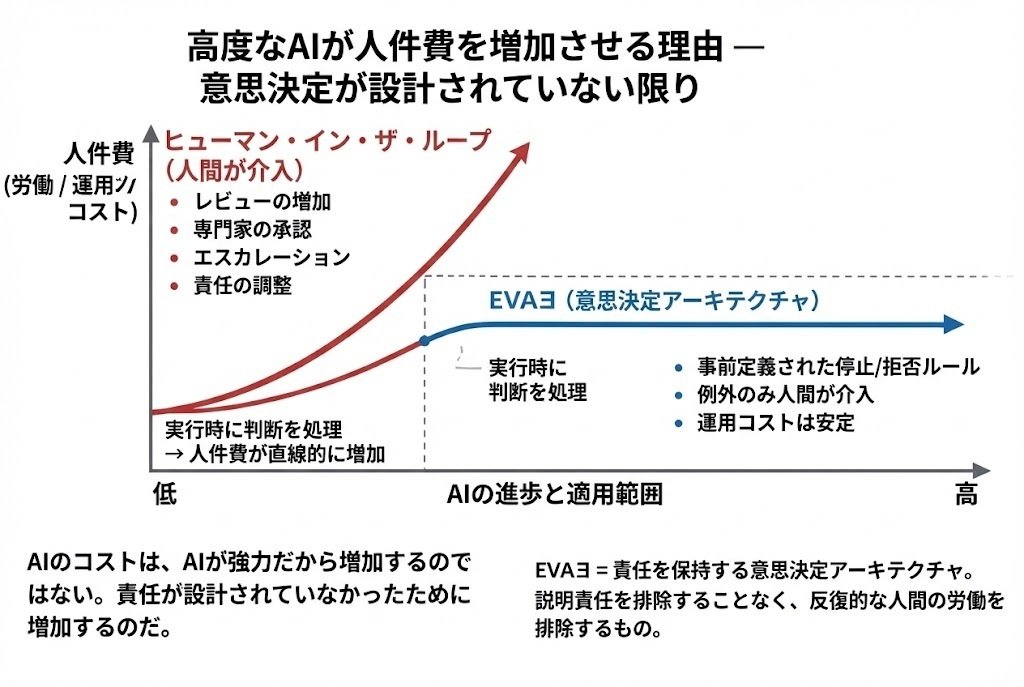

この図が示しているのは、とてもシンプルな事実です。

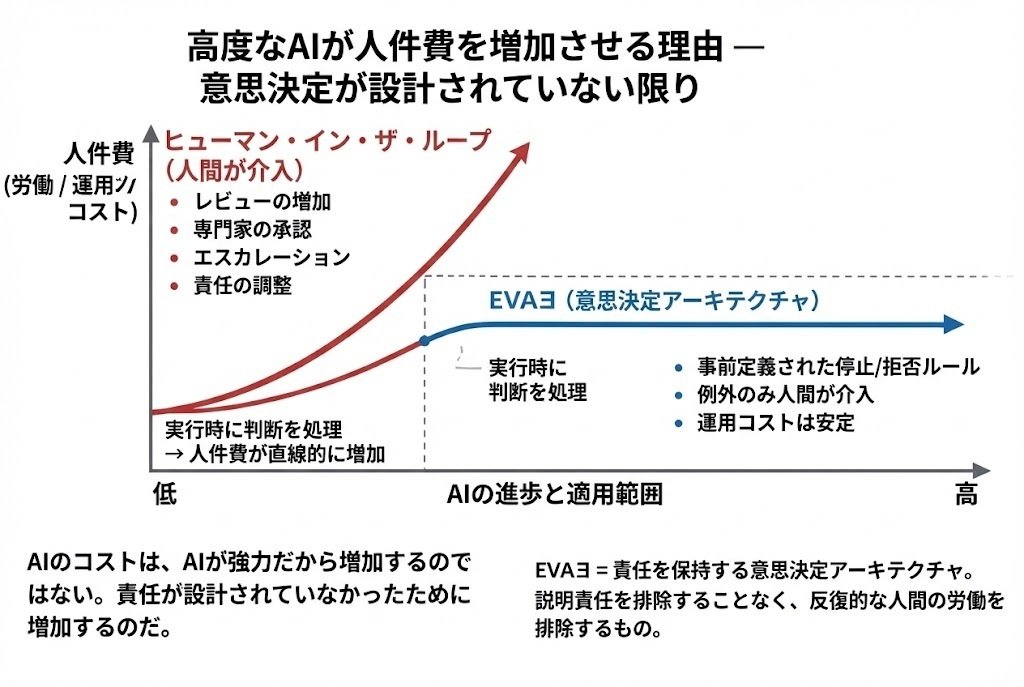

解決策「EVΛƎ」:責任とルールの事前設計により、AIが高度化してもコストを抑制。

解決策「EVΛƎ」:責任とルールの事前設計により、AIが高度化してもコストを抑制。

この図が示しているのは、とてもシンプルな事実です。

EVΛƎ(イーヴァ)は、この前提を反転させます。

EVΛƎは、

-

AIが判断してよい範囲

-

あらかじめ定義された停止・拒否ルール

-

例外時のみ人が介入するポイント

を、運用ではなく設計として先に固定します。

その結果、

-

判断が実行時に人へ流れ込む構造を防ぎ

-

責任を排除することなく

-

反復的な人間の労働だけを減らす

ことが可能になります。

これは、 AIを縛るための仕組みではありません。

AIを安心して使い続けるために、 人間側が先に責任を引き受ける設計です。

※補足として。

EVΛƎは、単なるアイデアや理想論ではありません。 この考え方はすでに、

さらに、この設計思想は、 海外のAI哲学者や技術者からも賛同を得ています。

特に、AIと責任構造を研究するレオン(政治哲学者/AIガバナンス研究者、Constellation Research Center 創設者)とは、 この考え方を実装・検証するための 共同研究の準備段階に入っています。

「設計から責任を固定する」という発想が、 現実のシステムとして成立するかどうか。 その検証フェーズに、すでに入っています。

これからのAIとの付き合い方

これからのAI活用:「AIの判断」と「人間の責任」をセットで考えるのが不可欠になる。

これからのAI活用:「AIの判断」と「人間の責任」をセットで考えるのが不可欠になる。

AIは、とても強力な道具です。

でも、

万能な「判断者」ではありません。

AIを安全に、安心して使うためには、

「AIが何をするか」だけでなく、

「人がどこで責任を持つか」を

一緒に考える必要があります。

EVΛƎは、

そのための一つの考え方であり、

これからの社会に必要になる

AI設計の前提条件だと考えています。

※この記事は、AIの仕組みを否定するものではありません。

AIを“使いこなすために必要な視点”を、

できるだけ分かりやすく伝えることを目的に書いています。

EVΛƎは、単なるアイデアや理想論ではありません。 この考え方はすでに、

-

学術論文として整理され

-

意思決定構造に関する特許として出願され

-

名称・概念は商標として保護され

-

実際に動くアプリケーションとして実装・検証が進められています。

-

さらに、この設計思想は、 海外のAI哲学者や技術者からも賛同を得ています。

-

特に、AIと責任構造を研究するDr. Leon TSVASMAN(政治哲学者/AIガバナンス研究者、Constellation Research Center 創設者)とは、 この考え方を実装・検証するための 共同研究の準備段階に入っています。

「設計から責任を固定する」という発想が、 現実のシステムとして成立するかどうか。 その検証フェーズに、すでに入っています。

横木 広(Hiro Yokoki)

EVΛƎ(イーヴァ)提唱者/研究・設計者

AI意思決定アーキテクチャ(Design-by-Transparency)

Amuletplus G.K.

🌐:https://amuletplus.co.jp/

✉️:info@amuletplus.co.jp