当 xAI 在 2025 年 8 月下旬宣布 **Grok Code Fast 1** 时,AI 社区收到了一个明确的信号:Grok 不再只是一个对话助手,而正在被武器化用于开发人员的工作流程。Grok Code Fast 1(缩写为 *Code Fast 1*)是一种低延迟、低成本的推理模型,专门针对编码任务和 *基于代理* 的编码工作流程进行了调整。基于代理是指模型在其中规划、调用工具并在 IDE 或管道中充当自主编码助手的工作流程。该模型已经开始出现在合作伙伴集成中(作为 GitHub Copilot 中的选择加入预览版)以及许多云和第三方提供商目录中,包括 CometAPI。

## 什么是 Grok Code Fast 1,它为什么重要?

xAI 的 **grok-code-fast-1** 是一种刻意关注低延迟的编码模型,旨在成为开发工具和自动化工作流程中的积极合作伙伴。 Grok Code Fast 1 定位于实用的“结对编程”,针对速度、代理工具使用(搜索、函数调用、代码编辑和测试)以及跨代码库的大规模上下文推理进行了优化。作为 xAI Grok 家族的专业成员,它优先考虑编码工作流程的两个关键方面:交互速度和经济的代币成本。它并非竞相成为最广泛、功能最丰富的通用工具,而是专注于开发人员的日常工作:阅读代码、建议编辑、调用工具(linters/测试)以及快速迭代。

如今的重要性:

团队越来越期望在 IDE 和 CI 中获得即时反馈。每次助手迭代都需要等待几秒钟,这会中断流程。Grok Code Fast 1 的设计初衷就是为了减少这种摩擦。它

支持函数调用、结构化输出和可视化推理轨迹,从而提升了多步骤任务(搜索 → 编辑 → 测试 → 验证)的自动化程度。这使得它成为代理编码系统和协同开发助手的理想之选。

### 为什么“代理”一词在这里很重要:

代理模型提供的不仅仅是“自动完成”。它可以:

- 决定调用哪些外部工具(运行测试、获取包文档);

- 将任务分解为子步骤并执行;

- 返回结构化的 JSON 结果,或以编程方式进行类似 Git 的更改。Grok

Code Fast 1 有意公开推理跟踪(允许开发人员在流式传输时检查思路链)并优先调用本机工具。这两个功能支持安全且可操作的代理编码。

## 性能和速度 Grok Code Fast 1

### 我们如何衡量 Grok 速度?

该模型品牌的“快速”指的是几个方面:

1. **推理延迟** — 生成代码或推理跟踪时的令牌吞吐量和响应时间。由于此模型针对低延迟进行了优化,因此它非常适合长时间运行的批处理作业以及交互式 IDE 循环(自动完成、代码建议、快速错误修复)。

2. **成本效率**——代币定价和模型配置旨在降低日常编码任务的每次使用成本。与更大、更通用的模型相比,第三方市场提供的代币定价和模型配置更低。3

. **开发者生产力**——工作流程的感知“速度”:开发者从提示到生成可执行代码的速度。这包括模型调用函数并返回结构化、可测试输出的能力。### 实际性能

说明

| 操作/模型 | Grok Code Fast 1(已测量)|

| --------------------------------------------- | --------------------------- |

| 简单行补全 | 瞬时 |

| 函数生成(5-10 行)| 少于 1 秒 |

| 复杂组件/文件生成(50 行以上)| 2-5 秒 |

| 大型函数重构 | 5-10 秒 |

### 性能比较

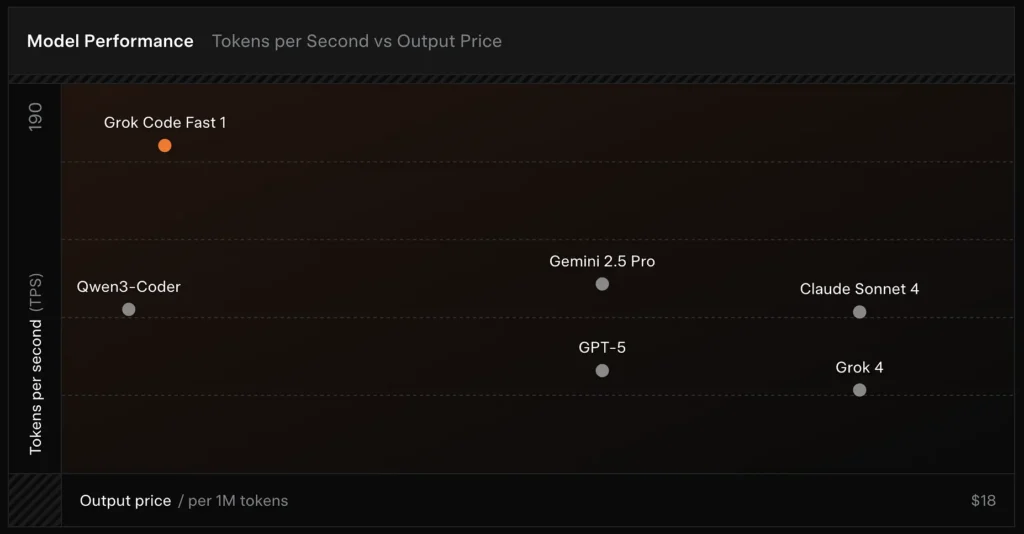

- 速度:测试达到 190 个代币/秒。

- 价格比较:GPT-5 输出每百万个令牌的成本约为 18 美元,而 Grok Code Fast-1 的成本仅为 1.50 美元。-

准确率:在 SWE-Bench-Verified 基准测试中得分为 70.8%。

### 提高速度的设计选择

- **大型上下文窗口(256,000 个令牌):**能够提取大型代码库和长对话历史记录而无需截断,从而减少了重复上传上下文的需要。([x.ai][1])

- **缓存友好提示**:模型和平台经过优化,可缓存代理步骤之间很少更改的前缀令牌,从而减少重复计算并改善多步骤工具交互的延迟。-

**原生工具调用协议**:Grok 的 API 支持结构化的函数/工具定义,而不是临时的 XML 或基于脆弱字符串的“函数调用”,模型可以在推理过程中调用这些定义(摘要或“思路”被流式传输回来)。这最大限度地减少了解析工作量,并允许模型可靠地组合多个工具。

## Grok Code Fast 1 提供哪些功能?

以下是 Grok Code Fast 1 对开发人员有吸引力的核心功能:集成。## 用例代码:Python(原生 xAI SDK,流式采样器)

> 此示例改编自 xAI 文档模式。将 `XAI_API_KEY` 替换为您的实际密钥,并调整工具定义以适合您的环境。流式传输将显示令牌和推理轨迹。

```

# 另存为 grok_code_fast_example.py

import os

import asyncio

# 假设 xai_sdk,如 xAI 文档中所述

import xai_sdk

API_KEY = os.getenv("XAI_API_KEY") # 安全保存您的密钥

async def main():

client = xai_sdk.Client(api_key=API_KEY)

# 示例:向您的模型添加单元测试并提示修复任何错误代码

prompt = """

存储库结构:

/src/math_utils.py

/tests/test_math_utils.pyTask

:运行测试,识别第一个错误的测试用例,并通过修改 src/math_utils.py 来修复错误

。显示最小代码差异并再次运行测试。

"""

# 启动流示例。我想要查看

client.sampler.sample 中 chunk 的推理跟踪异步(

model="grok-code-fast-1",

prompt=prompt,

max_len=1024,

stream=True,

return_reasoning=True, # Stream reasoning_content if available

):

# chunk 可能包含标记和推理跟踪 if

hasattr(chunk, "delta"):

if getattr(chunk.delta, "reasoning_content", None):

# 模型公开内部规划步骤

print("[REASONING]", chunk.delta.reasoning_content, flush=True)

if getattr(chunk.delta, "token_str", None):

print(chunk.delta.token_str, end="", flush=True)

if __name__ == "__main__":

asyncio.run(main())

```

**注意**

- `return_reasoning=True` 标志根据文档指南对推理跟踪进行流式传输,允许您通过捕获和显示来审核模型的计划它们。-

在真实的代理环境中,你还可以注册工具(例如 `run_tests`、`apply_patch`)并允许模型调用它们。这允许模型决定是否调用 `run_tests()` 并使用其输出来应用补丁。------

##

用例代码:REST(兼容 CometAPI / OpenAI)

> 如果你的堆栈需要 OpenAI 风格的 REST 端点,**CometAPI** 会将 `grok-code-fast-1` 公开为兼容的模型字符串。以下示例使用 `openai` 风格的客户端模式。``` import

os

import requests CometAPI_KEY = os.getenv("CometAPI_API_KEY") BASE = "https://api.cometapi.com/v1/chat/completions" headers = { "Authorization": f"Bearer {CometAPI_KEY}", "Content-Type": "application/json",}有效载荷 = { “模型”:“grok-code-fast-1”,“消息”:[

{"role": "system", "content": "您是 Grok Code Fast 1:快速编码助手。"},

{"role": "user", "content": "编写一个 Python 函数,将两个排序列表合并为一个排序列表。"}

],

"max_tokens": 300,

"stream": False

}

resp = requests.post(BASE, json=payload, headers=headers)

resp.raise_for_status()

print(resp.json())

```

**注意**

- 如果您的环境在本机 gRPC 或 SDK 访问方面存在问题,**CometAPI** 可充当桥梁。CometAPI 支持 256k 个上下文并公开 `grok-code-fast-1`。检查提供商可用性和速率限制。

## 什么是实用的集成模式和最佳实践?

### IDE 优先(结对编程)

将 Grok Code Fast 1 合并到 VS Code 或任何其他 IDE 中作为完成/辅助模型。使用简短的提示进行小的、可测试的编辑。让助手保持紧密循环:生成补丁→运行测试→使用失败的测试输出重新运行助手。

### CI 自动化

使用 Grok Code Fast 1 对不稳定的缺陷进行分类并建议修复或为新添加的代码自动生成单元测试。与更昂贵的通用模型相比,它的低延迟定价和设计使其适合频繁的 CI 运行。

### 将代理编排

模型与强大的工具保护相结合。始终在沙箱中运行建议的补丁,运行完整的测试套件,并要求人工审查关键的安全或设计更改。审核操作并通过可见的推理跟踪使其可重现。

### 提示工程提示

- 提供模型的精确文件或一个小的、集中的上下文窗口以进行编辑。-

为差异和 JSON 摘要推荐结构化输出模式。这使得自动验证更容易。-

运行多步骤流程时,记录模型的工具调用和结果,以便您可以重放或调试代理行为。

### 具体用例:自动修复失败的 Pytest 测试

下面是一个简化的 Python 工作流程,展示如何将 Grok Code Fast 1 集成到您的测试修复循环中。

```

# 伪代码:使用 grok-code-fast-1 的代理测试修复循环

# 1) 收集失败的测试输出

failing_test_output = run_pytest_and_capture("tests/test_math.py")

# 2) 要求 Grok 建议补丁和测试

prompt = f"""

Pyproject: repo root

failing_test_output:

{failing_test_output}

请帮助我们完成以下工作:

1) 简要描述根本原因。2

) 提供以统一差异格式修复问题的补丁。3

) 建议一组最少的新/更新的单元测试来证明修复。

"""

resp =

### 核心功能

- **代理编码**:内置支持调用工具(测试运行器、linters、包搜索、Git 操作)和创建多步骤工作流。

- **流式推理追踪**:在流式模式下使用时,API 会公开中间“推理内容”,允许开发者和系统在模型规划过程中进行观察和干预。-

**结构化输出和函数调用**:返回适合编程使用的 JSON 或类型化结果(而不仅仅是自由格式的文本)。-

**超大上下文(256k 个令牌):**非常适合单会话文件到文件任务。-

**快速推理**:创新的加速技术和提示缓存优化显著提升了推理速度。响应速度非常快,通常在用户读完提示之前就已经完成了数十次工具调用。-

**代理编程优化**:常用开发工具:grep、终端操作、文件编辑。与 Cursor、GitHub Copilot 和 Cline 等主流 IDE 无缝集成。-

**编程语言支持**:** 我们拥有丰富的语言技能,包括 TypeScript、Python、Java、Rust、C++ 和 Go。我们可以处理任何开发任务,从从零开始构建项目到排除复杂代码库的故障以及细致的错误修复。

### 开发人员工效学

- **OpenAI 兼容 SDK 接口**:xAI 的 API 优先考虑与热门 SDK 的兼容性,并提供迁移指导以缩短开发人员入职时间。

- **CometAPI 和 BYOK 支持**:**CometAPI 等第三方提供商通过 REST 向需要 OpenAI 兼容端点的团队公开 Grok Code Fast 1。这简化了与需要类似 OpenAI API 的工具链的集成。

### Grok Code Fast 1 与通用 LLM 有何不同?

Grok Code Fast 1 牺牲了其旗舰对话模型的广度,以便更紧密地调整代码、开发人员工具和快速工具循环。具体而言:

- 令牌生成和工具调用的往返延迟更快。-

以操作为中心的输出(结构化响应、JSON/函数调用元数据)。-

针对大量代码交互调整的成本模型(许多网关列表的每个令牌成本较低)

## Grok Code Fast 1 的代理性如何?“代理编码”实际上是什么意思?

“代理”是指模型可以规划和执行涉及与外部工具交互的多步骤任务。在 Grok Code Fast 1 中,代理的强大功能体现在以下方面:

- **函数调用**:Grok 可以请求调用外部函数(例如,运行测试、检索文件、调用 linter),并将返回的结果整合到后续决策中。-

**可视化推理轨迹**:输出可能包含可供检查的逐步推理,以调试或控制代理的行为。这种透明性在自动化整个代码库的更改时非常有用。-

**持久工具循环**:Grok 旨在用于计划 → 执行 → 验证的短小迭代循环,而不是期望单一的整体响应。

### 从代理行为中受益最多的用例

- 自动代码修复:识别失败的测试、建议修改、运行测试并进行迭代。

- 存储库分析:在数千个文件中查找使用模式,创建摘要,或使用精确的文件/行引用建议重构。

- PR 生成协助:编写 PR 描述、生成差异补丁和注释测试,所有这些都在可在 CI 中运行的编排流程中进行。

------

## 开发人员如何访问和使用 Grok Code Fast 1 API?

xAI 通过公共 API 和合作伙伴集成公开 Grok 模型。有三种常见的访问模式:

- **直接 xAI API** — 创建 xAI 帐户,在控制台中生成 API 密钥,然后调用 REST 端点。xAI 文档将 REST 基础标识为“https://api.x.ai”并指定标准 Bearer 令牌身份验证。文档和指南提供了 curl 和 SDK 示例,并强调了与跨多个工具层的 OpenAI 风格请求的兼容性。

- **IDE/服务合作伙伴(预览集成)** — GitHub Copilot(可选公开预览版)和其他合作伙伴(例如 Cursor、Cline)已宣布成为发布协作者,允许您在 VS Code 等工具中启用 Grok Code Fast 1。这可能涉及“自带密钥”流程。如果您使用的是 Copilot 的专业版或企业版,请查看 Grok Code Fast 1 的可选选项。-

**第三方网关(CometAPI、API 聚合器)** — 供应商会标准化不同提供商之间的 API 调用,有时还会提供不同的定价结构(这对于原型设计或回退到多个提供商非常有用)。像 **CometAPI** 这样的注册表列出了模型上下文、示例定价和示例调用。

下面是两个工作代码示例(Python Native SDK 流式传输和通过 **CometAPI** 的 REST),展示了如何在真实应用中使用 Grok Code Fast 1:

> **设计你的工具:**在请求中注册函数/工具定义,以便你的模型可以调用它们。对于流式传输,捕获 `reasoning_content` 以监控模型的计划。------ #

call_grok_model ("grok-code-fast-1", prompt, show_reasoning=True) # 3) 从响应中解析结构化补丁(验证!)patch = extract_patch_from_response(resp) if is_patch_safe(patch): apply_patch (patch) test_result = run_pytest_and_capture("tests/test_math.py") report_back_to_grok(test_result) else:

alert_human_review(resp)

```

此循环演示了如何实现类似代理的行为(提议→验证→执行→迭代),同时让开发人员控制更改的应用。

##简介

CometAPI是一个统一的API平台,它将来自领先提供商的500多个AI模型(包括OpenAI的GPT系列,Google的Gemini,Anthropic的Claude,Midjourney和Suno)聚合到一个开发人员友好的界面中。通过提供一致的身份验证,请求格式和响应处理,CometAPI大大简化了将AI功能集成到应用程序中的过程。无论您是构建聊天机器人,图像生成器,音乐创作工具还是数据驱动的分析管道,CometAPI都能实现更快的迭代,更低的成本和与供应商无关的环境,同时利用整个AI生态系统的最新突破。

开发人员可以通过CometAPI访问Grok Code Fast 1 API。最新的模型版本始终在官方网站上更新。首先,在 Playground 中检查模型的功能,并参阅 API 指南了解详细说明。访问之前,请确保您已登录 Comet API 并获取 API 密钥。为了协助集成,Comet API 提供的价格远低于官方价格。

准备好了吗?→立即注册 Comet API!

------

## 摘要

Grok Code Fast 1 并非宣传为最适合每项工作的唯一模型。相反,它是一个专家。它针对代理和工具丰富的编码工作流进行了优化,其中速度、大上下文窗口和低成本的每次迭代至关重要。这种组合使它成为许多工程团队的实用日常工具。它足够快,可以提供实时编辑器体验,足够经济高效,可以进行迭代,并且足够透明,可以在适当的边界内安全地集成。