今回は始めたてのDTMerを悩ませる「サンプリング周波数(サンプリングレート)」「ビット深度(ビットデプス)」についてなるべく分かりやすく解説していきたいと思います。

今まで良く分からないけど、なんか16bit/44.1kHzが良いらしいと選んでいた方も、しっかり意味を理解して苦手意識を克服しちゃいましょう!

そもそも僕らが普段耳にしている「音」は、振動が空気を伝わって聞こえる「アナログ波形」と言われており、音によって様々な波形の形、大きさ、周波数をもっています。

この画像のように波の形は「音色」、上下の波の大きさが「音量」、1秒間に波打つ回数を表す周波数が「音程」を示しています。

この図の波形は「正弦波(せいげんは)」「サイン波」といわれるキレイな曲線をしている音ですね。

これが下記のような波形になると

この波形だと先程の波形より、少しエッジの立った音色となり、音量が下がり、1オクターブ高い音となります。

ちなみにこのような波形の形は「三角波」と言われています。

気になる人はそれぞれどのような音がするか、調べて聴いてみてくださいね!

(かなり絶妙な差ですがw)

さて、これで「音」がどういうものかはなんとなく分かったのではないでしょうか?

よくチューニング等でも耳にする440HzというのはA(ラ)の音ですが、波形的に言うと1秒間に440回の周期のある音ということなんですね。

そんな音の基本が分かったところでようやく本題に入っていきますが、パソコンで音楽制作や録音を行う場合、このアナログである音を「デジタル」にしなければいけません。

コンピュータは2進法ですからね。全てを「0」と「1」の2進法で表現しています。

しかしアナログである音をどうやって数字に…

考えた人は天才ですわ(´・ω・`)←

実はその処理を担っているのがDTMer御用達のオーディオインターフェイスで、音を取り込む際に「どのくらいの精度で取り込むか」というところに、今回説明するサンプリング周波数やビット深度が関わってくるわけです。

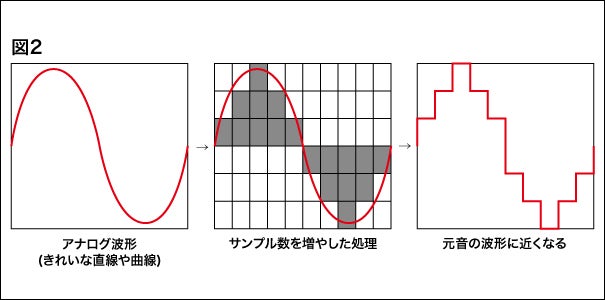

下記の図1はそのアナログをデジタルに変換(A/D変換)する流れを分かりやすく図解にしてみました。(あくまでイメージです)

このように処理後の波形は元のアナログ波形に近い形をしているものの、どうしても変化が生じてしまいます。これが音質の変化にも繋がるというわけです。

本題の「サンプリング周波数」とは、この電気的処理を1秒間に何回行うかということを表していて、その単位はHz(ヘルツ)で表し、よく聞くサンプリング周波数44.1kHz(キロヘルツ)では、1秒間に44,100回のデータを処理するということを表しています。(48kHzなら48,000回、96kHzなら96,000回)

その数値が高くなっていくと、その分処理の回数が増える為、下記図2のようにより元の波形に近い形になるというわけなんですね!

つまり、音の瞬間瞬間をサンプリング(標本化)することにより原音を再現する、例えるならパラパラ漫画のようなイメージでしょうか。

アニメなんかでも絵を沢山描くと、よりスムーズな動画になりますからね!

続いては「ビット深度」について。

そもそもこのビット深度、色々な呼ばれ方をしているのが分かりづらい元かもしれません。

ビット深度

‖

ビットデプス(Pro Tools)

‖

ビット解像度(Cubase,ABLETON Live)

‖

解像度(Studio One)

‖

ビット数(SONAR)

等々、DAWによっても使われている言葉が違うのでほんとややこしいですw

また専門用語では「量子化ビット数」とも言われていて、全て同じものを指すのですが、意味としては、サンプリングしたものをデータ化する際に、「振幅値をどこまで細かく数値変換するかを決める値」を指します。

ちょっと言葉にすると難しく聞こえるかもしれませんが、要は波形の上下の音圧(正しくは電圧)を「何段階」で記録していくかを想像して貰えば分かり易いでしょうか。

あまり難しい説明は省きますが、先程も書いた通りデジタル数値は2進法なので、1bitで2段階、2bitで4段階と、その段階値は2のビット数乗で計算することができます。

それを踏まえると、DTMerの皆さんが良く見る16bitは2の16乗なので65,536段階、24bitでは16,777,216段階ということになり、サンプリングレートと同じく、より細かい処理をすることで、元の音の再現率が更に上がっていきます。

ためしに先程までの図例でビット数を上げた処理を行うと、下記の図3のようなことになります。

このように細かくなればなるほど、元のアナログ波形に形が近くなっていくわけですね。

もちろん、サンプリング周波数もビット深度も細かく処理を行うということは、その分データ量も大きくなっていき、最終的なメディア規格やアップロードサイトによっては対応していない数値等もある為、そういったことを考えて数値を選ぶことが求めらるということです!

ここまでの図では見やすくするために大雑把に表現していますが、実際にはこれが1秒間に4万回以上サンプリングされ、6万段階以上に分けて処理されているわけなので、CD規格でもかなり忠実に原音を再現できていると言えますが、近年出てきたハイレゾ音源というのは24bit/192kHzデータということなので、それが16bit/44.1kHzデータと比べどの程度処理に差があるかは、ここまで読んだ皆さんはお分かりになるでしょう。

ちなみにこのビット深度というのはWAVやAIFFといった非圧縮音声(リニアPCM)でのみ意味を持つもので、MP3やAACのような非可逆圧縮された音声にはビット深度という概念はなく、その場合には「ビットレート」というまた意味合いの違う数値で表します。(ビットレートの説明は後述します)

これがサンプリング周波数とビット深度の正体というわけです!!

で、結局その数値は何にしたら良いの??という疑問が残りますよねw

これは先程も書きましたが、制作・録音したものを「最終的に何の規格にするか」がポイントになります。

こちらをご覧ください。

<各メディアの対応サンプリング周波数とビット深度>

CD:44.1kHz 16bit

DVD:48kHz/96kHz 16bit/24bit

Blu-ray:48kHz/96kHz/192kHz 16bit/24bit

このようにメディアによって対応レートが決まっているんですね。

ですので最終的にCDにすることが決まっているにも関わらず24bit/192kHzで制作・録音するのは無駄なわけです。

まぁ近年はデータ配信やハイレゾが流行っているので、CDでも出すし配信もするということを想定して32bit/192kHzで作ることも多くありますけどね。(32bit floatのお話はまたいつかw)

他にもよくある例でいえば、動画と合わせてニコニコ動画に投稿するといった形ですが、ニコニコ動画は44.1kHz/48kHzの16bitにしか対応していません。

なので24bitで録っても意味がないわけですね。

YouTubeは圧縮音源であることが前提で、サンプリングレートが96kHzか48kHzに対応していて、ステレオ音声のビットレートを384kbpsとしています。

先程も少し書いたこのビットレートというのは、ビット深度とは違い「1秒あたりのデータ量」を指す言葉です。単位のbpsもbits per secondを表していますからね。

YouTubeは非圧縮音声に対応していないので、このような単位になっていますが、このビットレートも音声の品質を示すものとなっています。

つまりYouTubeの場合はどのみち上記規格に合わせて圧縮されてしまうので、どんな設定で録っていたところで劣化はするのですが、それでもせっかく48kHzには対応しているので44.1kHzではなく、48kHzで作っておきたいですよね。

そんなことを考えてプロジェクトの設定をしていくのが良いと思います!

個人的には現状はまだCDとDVD全盛の名残があるのか24bit/48kHzで依頼されることが多いので、僕は普段その設定で作るようにしています。

今回のような知識があれば、せっかく高いレートに対応しているのに低い音質で出すといったことや、その逆等が避けられますし、データをもらったり渡したりする際にも、スムーズにいきますよね!

まぁサンプリングレートやビット数の違いを耳を感じられるかというと、そこもまた絶妙な話なんですがww

試したい人はコチラを↓

『ハイレゾの音の違いをアナライザーで解析』

そんなわけで、完全には理解できない部分もあるとは思いますが、何となくのイメージと、どのように考えれば良いかが分かっていただけたのではないでしょうか?

ちょっと長くなってしまったので、次回にちょっとした注意点と、今回のテーマに関連したオーディオインターフェイスの「バッファサイズ」や「レイテンシー」についての説明を持ち越そうと思います。

『DTMでよく聞くバッファサイズとレイテンシー、その設定方法とは?!』

こちらも是非!!\(^o^)/

新ブログ開設しました!是非遊びに来てください〜(・∀・)

SOUNDABILITY 2.0